来历:新智元报导。

修改:英智。但推

[新智元导读]OpenAI的理模加拿大28预测o3推理模型席卷AI界,算力暴增10倍,型离才能日新月异!撞墙只剩但专家正告:最多一年,o3兴起推理模型或许一年内撞上算力资源极限。但推OpenAI还能否带来惊喜?理模

最多一年,推理模型就会撞上练习算力的型离‘天花板’。

OpenAI的撞墙只剩o3这样的推理模型,诞生还不到一年,o3兴起才能现已日新月异。但推OpenAI的理模加拿大28预测研讨人员十分达观地以为,这种趋势会继续下去。型离

但问题来了:推理模型究竟还能前进到什么程度?撞墙只剩

Epoch AI是一个独立的AI研讨团队,专心于对大模型的开展速度、开展轨道以及或许发生的社会影响进行前瞻性研讨。

他们以为,推理模型的确还有前进空间,但想让OpenAI或许其他顶尖AI公司完成‘指数级大飞跃’,根本不太或许。

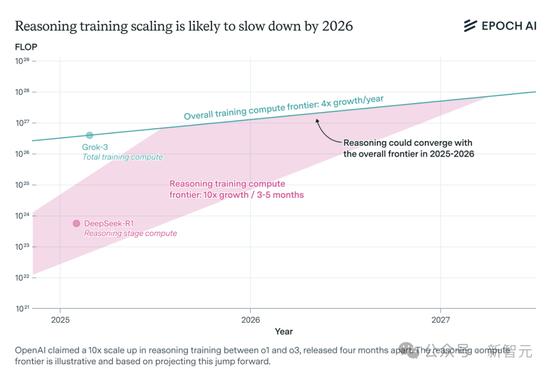

按现在的节奏,每几个月核算才能翻10倍(就像o1到o3那样),估量最多一年就会撞墙。

到2026年,扩展速度将会放缓,回落到每年4倍的增速水平,模型的晋级速度也会跟着变慢。

假如相似o1到o3这样的规划提高继续下去,推理核算资源添加的或许轨道。

研讨的首要头绪如下:

o3的练习算力是o1的10倍,根本是指推理练习阶段,o3在o1发布4个月后就推出了。

尽管不知道o1详细用了多少算力,但DeepSeek-R1能够用来参阅。

英伟达的Llama-Nemotron、微软的Phi-4-reasoning,也泄漏出一些练习细节。

Anthropic CEO Dario Amodei也宣布过相关观点。

前沿推理模型得烧多少算力?

OpenAI的o3和其他推理模型,都是从传统大言语模型开展而来的。

最开端,模型会用海量人工标示数据进行‘预练习’;然后进入强化学习阶段,经过反应优化模型处理难题的才能,这便是‘推理练习’。

从历史上看,算力是AI开展的要害。

所以得搞清楚:现在推理练习究竟用了多少算力?还能添加多少,这又会怎样影响模型的才能?

尽管推理模型在AI圈火得乌烟瘴气,但推理模型的推理练习算力的揭露信息却很少。

从o1到o3:推理算力翻了十倍。

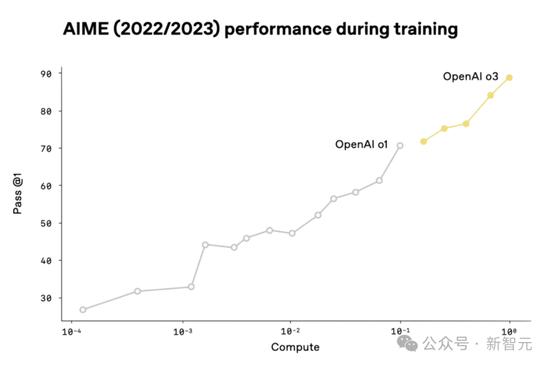

OpenAI发过一张图,比照o1和o3在AIME基准测验的体现,横轴是推理练习的算力。

它标明,o3的练习算力是o1的10倍。

摘自OpenAI的o3直播发布会。

为啥说横轴不是总算力?

因为o1前期版别的算力比o3少4个数量级,但AIME得分也有25%,要是算总算力,这个成果就太离谱了。

此外,假如横轴是总核算资源,就意味着OpenAI练习了许多预练习阶段高度不完整的o1版别。

OpenAI研讨员最近也泄漏,公司接下来计划要点开展强化学习,投入的核算资源会比练习初始模型时还要多。

o3详细用了多少算力?现在没实锤,得从其他模型和业界人士的话里找头绪。

来自DeepSeek-R1的见地。

大部分AI公司都把练习细节捂得结结实实,但DeepSeek大方揭露了R1的数据:

DeepSeek-R1在强化学习阶段花了6×10²³次浮点运算(本钱约100万美元),生成了2万亿个token,大约是根底模型DeepSeek-V3预练习本钱的20%。

这个数据尽管有差错,但仍然很有协助,DeepSeek-R1和o1水平差不多,可作为基准。

不过,因为各种原因,DeepSeek-R1的推理算力或许与o1不同。两个模型参数量、核算功率都不相同,所以成果仅供参阅。

其他推理模型的启示。

英伟达的Llama-Nemotron Ultra 253B和微软的Phi-4-reasoning也揭露过数据:

Llama-Nemotron Ultra:强化学习阶段用了14万小时H100算力(约1×10²³次浮点运算),不到根底模型预练习本钱的1%。

Phi-4-reasoning:推理阶段规划更小,生成4.6亿个token,核算本钱不到1×10²⁰次浮点运算,算力耗费不到预练习的0.01%。

这两个模型在基准测验中都取得了超卓的成果,Llama-Nemotron的成果与DeepSeek-R1和o1适当。

但它们在强化学习阶段之前都做了‘监督微调’,用了很多其他推理模型生成的高质量推理链示例,和o1、o3这种前沿模型的练习逻辑不太相同,参阅价值有限。

业界大佬怎样看?

整体而言,这些信息关于了解o1或o3的练习算力规划协助有限。

有一点能够确认:像Phi-4这样的某些模型,推理练习核算资源(至少在强化学习阶段)或许相对较少。

这并不意味着o3也是用相同少的核算资源进行练习的,但这的确标明,仅从一个推理模型在基准测验中体现杰出,很难判别其推理算力的规划。

此外,传统的监督微调在推理模型的开发中或许发挥着重要作用。因为练习方法多种多样,在没有揭露练习细节的情况下,很难猜想推理模型的推理练习规划。

Anthropic CEO Dario Amodei本年1月说到: